↧

`Federal´, un documental en buena hora

↧

Vamos a comprar mentiras

Vamos a comprar mentiras

Tapa blanda: 368 páginas

Editor: Calamo; Edición: 1 (22 de febrero de 2016)

ISBN-10: 8496932958 http://naukas.com/…/resena-vamos-a-comprar-mentiras-alime…/…

Con bisturí de cirujano y fina ironía, López Nicolás analiza con detalle la desvergüenza de algunas de las principales industrias alimentarias y cosmetológicas actuales. Es llamativo porque son empresas con enormes beneficios, con buenos laboratorios de I+D, con un cuidado exquisito por su imagen de marca y que, sin embargo, mienten, tergiversan, ocultan y engañan. A menudo con trucos de leguleyo, la letra pequeña, el asterisco, la media verdad que es una doble mentira. Jose Scientia, como muchos le conocemos, lo demuestra con una gran elegancia, fruto sin duda del rigor. Realmente a menudo lo que hace es tan solo contraponer lo que dice la empresa en su bote de yogur o de crema hidratante y lo que han dicho las principales agencias internacionales al respecto: la Agencia Europea del Medicamento, la FDA, los reglamentos de la Unión Europea, las asociaciones médicas y un largo etcétera. Así, por los capítulos de este libro van pasando las pastillas para adelgazar, los alimentos funcionales, las bebidas energéticas, los desodorantes, los dememoris, los nanoalimentos y muchos más. Todos son sometidos a esta mirada crítica, que no se deja embaucar por el envoltorio ni los mensajes publicitarios, y se centra en lo que los científicos tanto valoramos, los datos, las evidencias, los análisis independientes, que son expuestos de una manera sencilla y clara pero también rotunda y sin paños calientes.

La ciencia es una aventura fascinante, una de las pocas actividades humanas que tiene tres pies, uno en el pasado, otro en el presente y otro en el futuro. Es un ámbito abierto y generoso, pasional y competitivo. Y es la partida en la que se juega nuestro futuro. Sí, aunque a alguno le sorprenda, el futuro de nuestros hijos, de tu país, de la humanidad, no depende de las semifinales de la Champion.

La solución al paro, la mejora de nuestra competitividad económica, la posibilidad de alargar nuestra esperanza de vida, de detener el cambio climático o de luchar contra la desaparición de los insectos polinizadores no dependen de las alineaciones de Del Bosque, sino de si este país tiene un hueco para la ciencia en sus presupuestos, en el debate político, en sus medios de comunicación, en sus universidades, en sus librerías.

La ciencia es también el eje de nuestra sociedad moderna, desde internet a los trasplantes, desde las ondas gravitacionales a los teléfonos inteligentes. A veces los científicos sufrimos un cierto desánimo. Vivimos en un país democrático y avanzado donde, sin embargo, algunas personas se muestran totalmente analfabetas en ciencia hasta el extremo de no vacunar a sus hijos provocando que mueran de difteria. O donde supuestos profesionales sanitarios, aprovechándose del desconcierto reinante, despluman a los incautos vendiéndoles homeopatías y reikis varios. Por eso es importante la ciencia, por eso es necesario llevar los conocimientos científicos a toda la sociedad.

Afortunadamente, en los últimos años disfrutamos de una auténtica eclosión de autores, libros y editoriales dedicados a los libros de ciencia, la ciencia popular, la divulgación científica, la ciencia para todos, llámalo como quieras. Este es un género que puede llegar a combinar todas las virtudes de la buena literatura: amenidad, rigor, capacidad formativa, pensamiento crítico… Pienso que es otra cualidad de las culturas avanzadas, que la no ficción sea tan interesante y respetada como la ficción.

Con esta filosofía, ha nacido la colección El Arca de Darwin, de la editorial Cálamo, y fiel a estos principios publica ahora su segundo título, «Vamos a comprar mentiras. Alimentos y cosméticos desmontados por la ciencia», de José Manuel López Nicolás, conocido por muchos como Jose Scientia.

López Nicolás, químico, profesor universitario y divulgador científico, ha conseguido que su blog, Scientia, tenga miles de seguidores. Y esto no es casualidad. Es resultado de una escritura amena, sin jerga, que logra acercar sus amplísimos conocimientos y su curiosidad a cualquier lector. Es el fruto de elegir buenos temas, explicarlos bien y tratar al lector como un interlocutor inteligente que quiere aprender más

Ahora José Manuel ha trasladado todo esto a su primer libro, «Vamos a comprar mentiras. Alimentos y cosméticos desmontados por la ciencia», y creo que hay pocos primeros libros que sean tan insultantemente buenos como este. No nos debemos extrañar. Cada capítulo es un destilado de años de trabajo en su blog, contestando a los curiosos y trolls que allí le visitan, años de investigación en el laboratorio y en el supermercado, de dar clases y conferencias, siendo una voz que clama en un desierto cada vez más poblado, el de los que creemos en la ciencia como forma de discriminar si algo es falso o es verdad. Es un libro que se lee de un tirón pero que está muy pensado y muy trabajado.

Con bisturí de cirujano y fina ironía, López Nicolás analiza con detalle la desvergüenza de algunas de las principales industrias alimentarias y cosmetológicas actuales. Es llamativo porque son empresas con enormes beneficios, con buenos laboratorios de I+D, con un cuidado exquisito por su imagen de marca y que, sin embargo, mienten, tergiversan, ocultan y engañan. A menudo con trucos de leguleyo, la letra pequeña, el asterisco, la media verdad que es una doble mentira. Jose Scientia, como muchos le conocemos, lo demuestra con una gran elegancia, fruto sin duda del rigor. Realmente a menudo lo que hace es tan solo contraponer lo que dice la empresa en su bote de yogur o de crema hidratante y lo que han dicho las principales agencias internacionales al respecto: la Agencia Europea del Medicamento, la FDA, los reglamentos de la Unión Europea, las asociaciones médicas y un largo etcétera. Así, por los capítulos de este libro van pasando las pastillas para adelgazar, los alimentos funcionales, las bebidas energéticas, los desodorantes, los dememoris, los nanoalimentos y muchos más. Todos son sometidos a esta mirada crítica, que no se deja embaucar por el envoltorio ni los mensajes publicitarios, y se centra en lo que los científicos tanto valoramos, los datos, las evidencias, los análisis independientes, que son expuestos de una manera sencilla y clara pero también rotunda y sin paños calientes.

Esta es, quizá, la aportación más valiosa del libro. Más allá de desmontar falacias y engaños en los que casi todos hemos podido caer y contra los que quedamos advertidos, nos da argumentos sólidos con los que afrontar estos productos en el futuro, nos ayuda a ser más críticos, a estar más atentos. A desconfiar, sí, pero entendiendo por qué hay que hacerlo y exigiendo a estas empresas que nos traten con respeto si nos quieren tener de clientes.

También descubrimos lo que hay de verdad y de mentira en estos productos, pequeñas perlas de conocimiento que nos dan herramientas para una comprensión más rica de los avances que están por llegar y de aquello que consumimos y consumiremos. Es ese pie que ya se adentra en el futuro.

Valoro a López Nicolás tanto como divulgador como buen amigo y colega, pero ante la pregunta, ¿lo recomienda porque aprecia al autor o porque merece la pena? la respuesta es clara, lo recomiendo porque creo realmente que es uno de los mejores libros del 2016.

http://naukas.com/2016/03/31/resena-vamos-a-comprar-mentiras-alimentos-y-cosmeticos-desmontados-por-la-ciencia/#comments

↧

↧

Previsiones no acertadas, en 1980 se indico que sólo quedaba petróleo hasta el 2010.¿Milenarismo?

¿Se quedará el mundo sin petróleo? Un recurso agotable que no se agotará

![]()

![]()

versus

En las últimas décadas son muchos los economistas y expertos que se han hecho esta pregunta. Parece evidente que el petróleo es un bien finito, sin embargo no tiene por qué agotarse. Cada vez cobran más fuerza los argumentos que se pueden esgrimir para creer que el 'oro negro' nunca se acabará, porque los seres humanos usarán otras fuentes de energía antes de que se extraiga el último barril de petróleo.

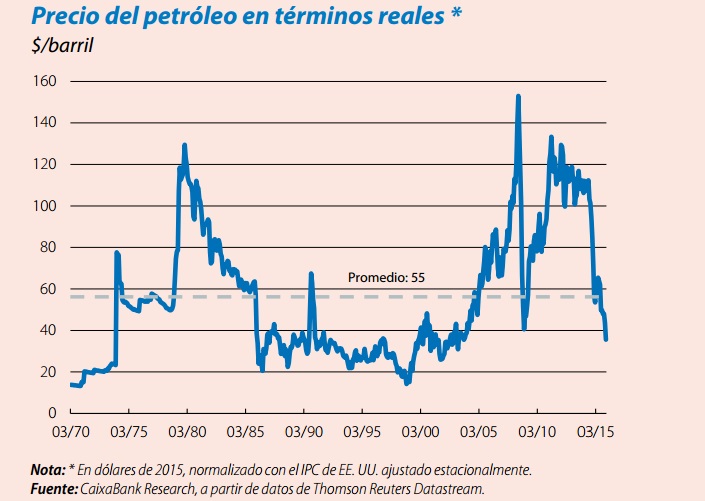

Así lo dejan entrever los investigadores de CaixaBank en su último informe, en el que analizan con detalle el pasado, presente y futuro del petróleo. Estos economistas muestran el precio del petróleo en términos reales (descontando la inflación) desde 1970 hasta el día de hoy. El gráfico no muestra una tendencia clara, simplemente ciclos derivados de factores que poco tienen que ver con la cantidad de reservas probadas.

Cada vez que los precios se disparan por determinadas circunstancias, la industria petrolera incrementa su inversión en exploración y tecnología para encontrar nuevas formas de extraer petróleo de forma más eficiente. Gracias a la tecnología aplicada a esta industria se puede extraer el crudo de aguas ultra-profundas o mediante perforación hidráulica.

"Apenas se aprecia la tendencia alcista de muy largo plazo del precio real del petróleo que cabría esperar de su condición de recurso agotable". El precio de un bien agotable cuya demanda es creciente (además de ser un bien fundamental para una gran parte de la humanidad) debería seguir una tendencia alcista a medida que este bien se va acabando. Y es que cada barril que se consume de petróleo supone que estamos más cerca delpeak oil. Sin embargo la tendencia del precio no refleja este fenómeno.

Como explican los expertos de CaixaBank, "la realidad ha deparado descubrimientos continuos de nuevos yacimientos, hasta el punto de que, en contra de lo que se esperaba, las reservas probadas extraíbles no han dejado de crecer durante estas cuatro décadas (desde 1973). Primero, por el hallazgo de campos convencionales en nuevos enclaves (Rusia, Venezuela, Nigeria, etc.) y, después, gracias los logros en la extracción de depósitos no convencionales (aguas profundas, arenas bituminosas, shale oil, etc.)".

Las reservas probadas de petróleo

Los cálculos realizados en 1980 mostraban que sólo quedaba petróleo para 27 años. Sin embargo, 45 años después (en 2015), se puede decir que queda petróleo al menos para 57 años. El incremento de las reservas probadas (la tecnología permite hoy extraer crudo con unos costes que antes no eran asumibles) y la diversificación energética hacen prever que las reservas probadas de crudo puedan seguir creciendo.

De este modo, el Departamento de Macroeconomía de CaixaBank, sentencia que el petróleo no llegará a agotarse. El mayor compromiso de gobiernos y ciudadanos para con el medio ambiente, el incremento de las reservas probadas y el avance de la tecnología evitarán que la extinción del petróleo.

"En nuestra opinión, hoy por hoy sugiere que la dinámica de largo plazo del precio del petróleo no se alejará de la observada durante las últimas cuatro décadas: oscilaciones, previsiblemente tan fuertes o más que en el pasado, alrededor de un nivel estable en términos reales equivalente a unos 55 dólares actuales. De confirmarse, sería prolongar el comportamiento propio de un recurso agotable que no se agotará, validando la famosa cita del jeque Zaki Yamani, ministro saudí de Petróleo durante los convulsos años setenta y ochenta: 'La Edad de Piedra no acabó porque se agotarán las piedras'"., sentencia el análisis.

http://www.eleconomista.es/materias-primas/noticias/7455180/03/16/Se-acabara-el-petroleo-El-recurso-agotable-que-nunca-se-agotara.html

La economía española y el petróleo: una relación estrecha

http://www.caixabankresearch.com/-/la-economia-espanola-y-el-petroleo-una-relacion-estrecha-d4

Petróleo: ¿un recurso escaso barato?

El precio del petróleo es una variable clave para la economía mundial y por ello es fundamental entender cuáles son sus principales determinantes a medio plazo, así como su evolución tendencial a largo. A esta cuestión dedicamos el Dossier del Informe Mensual de este mes. Como sucede con otros productos que cumplen también una función de activo financiero, los economistas renunciamos a tratar de explicar los movimientos a muy corto plazo. Renuncia que es muestra de ignorancia, pero tal vez también de sabiduría.

A medio plazo, el precio del crudo sigue los denominados superciclos. Es decir, periodos de alza y descenso cuya duración global es de aproximadamente 10 o 15 años. En esencia, estos superciclos son el resultado de la diferencia que existe entre las respuestas a distintos horizontes temporales por parte de los agentes (productores y consumidores) ante un cambio inicial en el precio. A corto plazo, la reacción de ambos es moderada (esto es, oferta y demanda son relativamente inelásticas al precio), pero a medio plazo sí se modifican en profundidad los comportamientos de producción y consumo. Dicho de otro modo, los bajos precios pueden prolongarse por un tiempo, pero precisamente este fenómeno desata las fuerzas que provocan, al cabo de unos años, aumentos estructurales de demanda y descensos de la oferta, que acarrean alzas significativas del nivel de precios. En los últimos 45 años, hemos vivido dos fases de aumentos acusados del precio (1973-1980 y 2002-2011), dos fases de fuertes descensos (1980-1986 y 2011-2015) y una inusitada fase de estabilidad en niveles bajos (1986-2002). Este último periodo es testimonio del carácter oligopolístico del mercado internacional del crudo, un factor que también determina crucialmente su devenir. El superciclo se interrumpe si, en la fase de potencial escasez de producción, el cartel del petróleo pierde cohesión y esto impide que, ante la presión de la demanda, los productores respondan con limitaciones de oferta.

Desde la perspectiva del superciclo, el Dossier de este mes argumenta que nos encontramos probablemente en el tramo final de la caída de precios, que ha sido de aproximadamente un 75% desde máximos de 2011, una cifra similar a la de los años ochenta. Si la OPEP es capaz de restablecer cierto grado de disciplina interna bajo el liderazgo de Arabia Saudí, deberíamos registrar mayores niveles de precios en el futuro, recuperándose los 60 dólares a lo largo de los tres próximos ejercicios y superándose los 70 dentro de cinco.

Por lo que respecta al largo plazo, el análisis económico nos indica que deberíamos observar una tendencia al aumento del precio en términos reales, es decir, del precio relativo del petróleo en la economía. Un recurso agotable debiera encarecerse conforme se agotan sus existencias. En la práctica, el precio real del petróleo ha oscilado mucho a lo largo de las últimas décadas, como hemos dicho, pero curiosamente ha revertido hacia una media que se sitúa en aproximadamente 55 dólares (de poder adquisitivo actual). Cuatro décadas ya cualifican como largo plazo, pero las reservas de petróleo han resultado ser mayores de lo esperado y probablemente esto explica que la tendencia al alza del precio haya sido prácticamente inexistente en este pasado medio siglo.

Mirando al futuro, es probable que esa tendencia al alza tampoco acabe de manifestarse. No porque las reservas aún por descubrir sean gigantescas o porque se esperen grandes avances tecnológicos que permitan explotar las fuentes de petróleo de manera más eficiente. Lo que probablemente impedirá ese aumento del precio a largo plazo será el impacto ambiental del consumo de petróleo: si la humanidad desea cumplir sus objetivos de control de emisiones de CO2, una parte importante de las reservas aún no explotadas de combustibles fósiles serán, de hecho, inservibles. La competencia entre fuentes de energía está servida. Esto introduce un fuerte incentivo para que los países productores de petróleo intenten colocar a tiempo sus reservas en el mercado, renunciando a pactos monopolísticos prolongados que podrían no ser más que pan para hoy y hambre para pasado mañana.

Jordi Gual

Perspectivas del precio del petróleo

Nadie reivindica haber predicho, ni siquiera de lejos, el espectacular desplome del 75% que sufrió el precio del petróleo entre junio de 2014 y diciembre de 2015. El carácter absolutamente excepcional de la confluencia de fuerzas que se produjo en tan breve tiempo constituye una disculpa comprensible. Pero lo cierto es que esta variable ha tenido casi siempre la rebelde costumbre de frustrar los pronósticos de los expertos. Con estos precedentes, conviene tomar los ejercicios de prospectiva con cautela, a modo de referencias orientativas. En este sentido, y todavía con la tormenta activa, nuestra valoración apunta, con elevada convicción, hacia un precio a medio plazo (unos cinco años) claramente por encima del actual. La senda hasta entonces está plagada de incógnitas, aunque lo más probable es que la recuperación ya sea perceptible antes de acabar este año. Respecto al largo plazo, no parece haber motivos para que el precio promedio en términos reales se aleje mucho del nivel observado durante las últimas cuatro décadas.

El escenario de una subida significativa del precio del crudo a medio plazo se sustenta en factores tanto del lado de la demanda como de la oferta, que interaccionarán según un patrón similar al que ha venido deparando la experiencia histórica descrita en el artículo previo de este Dossier. En el lado de la demanda, la evolución económica de los países emergentes, con China al frente, va a ser el determinante clave. Se solapan aquí las dimensiones cíclica y estructural. Respecto a la primera, pensamos que la mayoría de economías emergentes conseguirán, no sin tropiezos, recuperar el pulso tras varios años de adversidades. Los problemas aparecieron por la suma de ciertos desequilibrios internos (déficit de cuenta corriente, inflación, etc.), las perturbaciones derivadas de las idas y venidas de los flujos de capital internacionales (a su vez provocadas por la política monetaria de la Reserva Federal y otros bancos centrales de los países desarrollados) y la transformación y desaceleración de la economía china (que está frenando su consumo de materias primas). Posiblemente, la primera parte de 2016 constituya el valle de este ciclo y, contra el pesimismo ahora reinante, la recuperación no tarde en empezar. La estabilización de la economía china, en el sentido de conseguir el deseado y saludable cambio de modelo sin descarrilar, es un requisito básico. Si, como esperamos, eso es lo que ocurre, las condiciones serán propicias para el despliegue de fuerzas estructurales, en la propia China y en otros importantes países emergentes, que conducirán a un notable aumento de la demanda de crudo.

En efecto, más allá de los inevitables ciclos, es evidente que, desde que se superó la crisis asiática de la segunda mitad de la década de 1990, tanto el desarrollo industrial como el progreso social (expansión de las clases medias) ganaron consistencia en los países emergentes, de modo que muchos ya están cerca o han sobrepasado los umbrales que aceleran la demanda de transporte. Años atrás, el petróleo bien merecía su apodo de «oro negro», ya que era realmente prohibitivo. Pero los países no desarrollados cada vez tienen una cuota mayor del PIB mundial, tanto si se mide en paridad de poder adquisitivo como en dólares corrientes. Este progreso conlleva un aumento muy significativo de las flotas de vehículos industriales y, especialmente, la llegada de muchas familias a los niveles de renta que permiten la compra de un automóvil. Por ejemplo, en 2015, las ventas de

vehículos privados en China alcanzaron los 15 millones (cerca de los 17 millones de EE. UU.). Dado que solo el 25% de las familias chinas dispone de automóvil (frente a un 95% en EE. UU.), todavía queda mucho recorrido por delante en ese país. Y a China le seguirán, en un futuro cercano, otros países como la India, Indonesia, Pakistán, Bangladés, Brasil o Turquía, que suman más de 2.000 millones de habitantes.

vehículos privados en China alcanzaron los 15 millones (cerca de los 17 millones de EE. UU.). Dado que solo el 25% de las familias chinas dispone de automóvil (frente a un 95% en EE. UU.), todavía queda mucho recorrido por delante en ese país. Y a China le seguirán, en un futuro cercano, otros países como la India, Indonesia, Pakistán, Bangladés, Brasil o Turquía, que suman más de 2.000 millones de habitantes.

En las economías desarrolladas, el principal motivo para esperar cierto aumento de la demanda de crudo a medio plazo es de otra índole: las condiciones actuales de petróleo barato tienden a propiciar y consolidar hábitos de consumo sesgados hacia las gasolinas, a la vez que desincentivan la inversión (privada y pública) en eficiencia energética y en el desarrollo de fuentes alternativas (por ejemplo, en el ámbito del coche eléctrico). Posiblemente la magnitud de este factor no sea muy importante, en tanto que el precio de las gasolinas ha descendido mucho menos que el del crudo debido a los impuestos fijos que recaen sobre las primeras. Donde la influencia de los actuales precios bajos del petróleo va a percibirse con claridad a medio plazo es en el lado de la oferta. Para deprimirla. Las cifras de 2015 ponen de manifiesto que ya se está produciendo un retroceso brusco de la inversión en exploración y producción por parte de las compañías petroleras internacionales. Y también cabe esperar un descenso de los recursos financieros y técnicos destinados a los programas de investigación y desarrollo, que constituyen la fuente última de las mejoras de productividad en los yacimientos. Esto va a ir en detrimento de la capacidad de extracción de los próximos años. De hecho, hay motivos para pensar que este fenómeno va a ser más intenso que en el pasado. Uno es que el declive (por motivos geológicos, del número diario de barriles que se extraen de un pozo a no ser que se lleven a cabo inversiones adicionales para ahondar en la perforación o potenciar el bombeo) se manifiesta en la actualidad con una tasa (o velocidad) superior a la del pasado. Esto es así para los campos convencionales (porque ya han ido perdiendo mucha presión), pero sobre todo para los pozos de shale oil (muchos de los cuales suelen perder cada año nada menos que la mitad de producción diaria). Un segundo motivo también afecta con especial gravedad al segmento del shale: el descenso del precio del crudo ha sido tan brusco e inesperado que muchas empresas están en serios apuros financieros. Para ellas, recortar la inversión es un mal menor si consiguen sobrevivir. Pero muchas, ahogadas por la deuda, están sucumbiendo, con el consiguiente menoscabo del capital físico, humano y tecnológico en el conjunto del sector. Estos problemas se manifiestan también en determinados países productores que sufren desequilibrios macroeconómicos graves (déficits público y de cuenta corriente), necesidades sociales acuciantes y riesgos crecientes de inestabilidad política. Los casos de Rusia, Venezuela, Nigeria o Angola se cuentan entre los más preocupantes. Sometidos a semejante tesitura, sus respectivos Gobiernos se ven tentados a recortar las inversiones en capacidad extractora e incluso en mantenimiento de las instalaciones, lo que limitará la oferta dentro de no mucho tiempo. De hecho, con el agravante de la miopía característica de estos países, están apurando a muy corto plazo las posibilidades de producción, lo que contribuye a hundir aún más el precio actual. Paralelamente, intentan conseguir cierto respiro presionando a Arabia Saudí y a Irán para que asuman el sacrificio de contener la producción. Esto nos lleva al tercer gran determinante a medio plazo: el régimen competitivo entre los productores.

El factor clave para que el descenso del precio del crudo, que había empezado en 2011 y transcurría de forma muy gradual, se precipitara en el verano de 2014 fue el cambio de actitud de Arabia Saudí. Gracias a sus enormes reservas y a un bajísimo coste de extracción, el país puede absorber mejor que nadie los shocks transitorios que se producen en el mercado de crudo (swing producer). Eso es lo que hizo durante 2012-2013, cuando la llegada del shale oil al mercado empezó a ser relevante, y con el primer golpe a las economías emergentes (después del anuncio de la Reserva Federal sobre la finalización del QE). En el verano de 2014, los saudíes cambiaron la táctica de mantener el precio en la zona de 100 dólares por la de defender su cuota en la producción global. Es muy posible que tomaran esa decisión tras llegar a la conclusión de que la revolución shale no es un fenómeno efímero o marginal y que la ralentización de China y la fase de ajuste en otros emergentes no iban a ser cosa de unos pocos meses. Con dicho cambio, Arabia Saudí consigue dos objetivos. En primer lugar, frena a un competidor como el shale de EE. UU., cuyos costes de extracción son elevados y superan ahora el precio del petróleo. En segundo lugar, complica los planes de Irán de aumentar su producción ante la expectativa, recientemente confirmada, de que se levantarían las sanciones internacionales que le impedían vender libremente en el mercado. Irán tiene potencial (también por sus privilegiados volúmenes de reservas y costes de producción) para disputar a Arabia Saudí el liderazgo de la OPEP. Y, además de las consideraciones económicas, debe recordarse que la Arabia suní sostiene una creciente rivalidad político-religiosa con el Irán chií. Los propósitos saudíes van camino de cumplirse pero todavía no están asegurados, de modo que esta estrategia agresiva puede prolongarse durante algún tiempo (dispone de un buen colchón de divisas extranjeras y un nivel bajo de deuda pública). No obstante, la lógica indica que, conforme los productores de costes elevados como elshale vayan siendo expulsados, a la vez que la recuperación de los países emergentes se materialice, previsiblemente Arabia Saudí maniobrará para facilitar y aprovechar un contexto de precios más altos que los de ahora.

En suma, el crecimiento de la demanda de los emergentes, el retroceso actual de las inversiones en capacidad y la suavización de la rivalidad entre los productores son los tres motivos para esperar un aumento del precio del crudo a medio plazo. Nuestra previsión es de 70-75 dólares en 2020, un aumento considerable que supondría volver claramente por encima de la media histórica en términos reales. Este tipo de sobrerreacción ya ha ocurrido en el pasado ante dinámicas análogas a la que presentamos, de hecho, para llegar a cotas por encima de 100 dólares que en esta ocasión no parece razonable esperar (requerirían grandes sorpresas en los factores mencionados, en particular, la expansión del parque automovilístico en los países emergentes).

La senda que podría seguir el precio hasta la referencia indicada es difícil de anticipar. Lo más probable es que sea un alza gradual desde la segunda mitad de este año, de la mano, en primer lugar, de la reactivación de la economía global, que se encuentra en una fase de desaceleración que también afecta a los países desarrollados. Los efectos de la subinversión y la expulsión del shale se empezarán a percibir en 2017 y serán poderosos desde 2018, lo cual propiciará un impulso adicional al precio. Pero la rivalidad Arabia Saudí-Irán y, a su alrededor, las decisiones del conjunto de la OPEP y de otros productores destacados como Rusia, constituyen una gran incógnita que tiene visos de generar, antes de reconducirse y en cualquier momento, fuertes dosis de volatilidad.

De hecho, la estrategia saudí (y de otros países de su órbita, como Kuwait o Qatar) también puede estar influida por un factor de largo plazo cuya relevancia, sin embargo, va agrandándose: las implicaciones del riesgo del cambio climático para el sector internacional de la energía. Como se ha expuesto en el artículo previo de este Dossier, no se descarta en absoluto la posibilidad de que gran parte de las reservas probadas de combustibles fósiles (petróleo, gas natural y carbón) queden para siempre bajo el suelo si, como cabe esperar, los Gobiernos y los agentes privados acaban haciendo suyo el objetivo de poner un tope absoluto a las emisiones de CO2 liberadas a la atmósfera. El establecimiento de impuestos y restricciones al carbono, así como el fomento de programas públicos y privados de investigación en fuentes alternativas y eficiencia, pueden hacerla realidad. Ciertamente, un reto de esta magnitud requeriría largo tiempo, pero Arabia Saudí es consciente de que tiene reservas de crudo algo superiores a 60 años de su volumen actual de producción y que, a nivel global, la cifra alcanza casi los 50 años (véanse los gráficos dos y tres). En función del mapa de escenarios (económicos, políticos, tecnológicos, etc.) que esté contemplando, cabe la posibilidad de que la maximización del valor presente de todas sus ventas futuras le aconseje no sacrificar cuota y tolerar, o incluso propiciar, un precio que elimine o debilite a los rivales. De hecho, desde un enfoque de muy largo plazo, la competencia incluye también el resto de fuentes, como el carbón (que emite mucho más CO2 pero es mucho más barato), el gas natural (que emite menos), la nuclear, la hidroeléctrica o las renovables. Las innovaciones tecnológicas desempeñarán un papel crucial en dicha competencia. En nuestra opinión, hoy por hoy sugieren que la dinámica de largo plazo del precio del petróleo no se alejará de la observada durante las últimas cuatro décadas: oscilaciones, previsiblemente tan fuertes o más que en el pasado, alrededor de un nivel estable en términos reales equivalente a unos 55 dólares actuales. De confirmarse, sería prolongar el comportamiento propio de un recurso agotable que no se agotará, validando la famosa cita del jeque Zaki Yamani, ministro saudí del Petróleo durante los convulsos años setenta y ochenta: «la Edad de Piedra no acabó porque se agotaran las piedras».

Departamento de Macroeconomía,

Área de Planificación Estratégica y Estudios, CaixaBank

http://www.caixabankresearch.com/-/perspectivas-del-precio-del-petroleo_d2

versus

Consecuencias del cénit del petróleo

Aunque el mundo todavía no ha llegado al cénit de todos los tipos de petróleo (sí del petróleo convencional), algunas consecuencias de la proximidad del pico ya las hemos sufrido desde hace algo más de una década. Aunque parte de estas consecuencias han sido atribuidas a la coyuntura económica internacional, muchos picoileros creemos que elpetróleo influye mucho en la economía mundial.

http://crashoil.blogspot.com.es/2016/03/consecuencias-del-cenit-del-petroleo.html

↧

Neoludismo.Jordi Gual Economista jefe 31 de enero de 2016

Neoludismo

Vivimos una era extraordinariamente contradictoria. El renqueante crecimiento de las economías desarrolladas tras la gran crisis financiera de 2008 y los muy bajos tipos de interés reinantes desde hace años son, para economistas influyentes como Larry Summers o Robert Gordon, consecuencia del estancamiento secular. Es decir, de una tendencia a que el crecimiento económico sea cada vez menor debido a que ya no existen oportunidades significativas de mejoras tecnológicas.

Al mismo tiempo, se está difundiendo la idea de que las nuevas tecnologías de la información y la comunicación impulsarán la robótica y la inteligencia artificial hacia cotas desconocidas hasta ahora. De tal manera, se argumenta, dicho progreso técnico hará redundantes muchos puestos de trabajo, lo que afectará a las cualificaciones intermedias, ya que los robots serán capaces de llevar a cabo tareas cada vez más complejas, y no meramente mecánicas y repetitivas. Para muchos, las consecuencias sociales de estos avances serían nefastas, puesto que aumentaría la polarización de la sociedad, al centrarse las mejoras en los puestos de trabajo y los salarios de las clases medias.

Sin embargo, este es un relato incoherente, e incluso falaz. Si los avances tecnológicos y el progreso técnico causan problemas de empleo no pueden conducirnos al mismo tiempo al estancamiento y al marasmo económico. Las mejoras tecnológicas, como el propio término «mejora» indica, amplían nuestras capacidades. Ensanchan el potencial productivo. Permiten hacer más con menos. O, en el lenguaje de los economistas, expanden la frontera de producción, permitiendo que unos mismos factores productivos generen un mayor producto, es decir, más renta y, en última instancia, más bienestar.

El Dossier de este Informe Mensual trata de arrojar algo de luz sobre este debate. Su tesis central merece resaltarse ante la creciente presencia de ideas neoluditas en los medios de comunicación y algunas corrientes de opinión. El progreso tecnológico es bueno para nuestras sociedades y es además, en definitiva, el único factor de crecimiento económico y de generación de bienestar social que es inagotable. Los recursos naturales son finitos, los rendimientos del capital físico son decrecientes, pero no así la capacidad del ser humano de generar y difundir nuevas ideas.

El auge reciente de la visión neoludita se explica fundamentalmente por razones políticas. En primer lugar, los avances tecnológicos no son neutros en términos del reparto de sus beneficios en la sociedad. Y menos aún en lo que se refiere a sus efectos adversos, como ya sucedió en el siglo XVIII en Inglaterra con la introducción de los telares mecánicos que provocaron el movimiento ludita, que se dedicaba a destruir la nueva maquinaria.

En segundo lugar, la diseminación por toda la economía de las oportunidades que genera el progreso técnico depende en gran medida de cómo esté organizada la sociedad. Es decir, de sus instituciones económicas y sociales, y de si son suficientemente flexibles y dinámicas para adaptarse a las nuevas circunstancias y facilitar la aparición de nuevas ocupaciones, empresas y sectores que acaben sustituyendo los puestos de trabajo y las fuentes de bienestar y riqueza erosionados por el cambio tecnológico. La rigidez o adaptabilidad de estas instituciones es una cuestión eminentemente política, reflejo a menudo de la tensión y los intereses contrapuestos entre diversos grupos sociales. Entre aquellos, normalmente los grupos ya establecidos, que, bien organizados, se resisten al cambio, y los grupos emergentes que podrían aprovecharlo, que tienen a su favor el empuje de las nuevas ideas y tecnologías, pero que a menudo apenas constituyen un grupo homogéneo con suficiente poder político para alterar el statu quo.

Es un gran reto de las sociedades democráticas avanzadas encauzar este gran debate social y combate político de tal modo que se consiga promover el cambio tecnológico y, al mismo tiempo, asegurar que sus beneficios lleguen a toda la sociedad.

Jordi Gual

Economista jefe

31 de enero de 2016

Automatización: el miedo del trabajador

En un mundo donde las máquinas no solo ejecutan órdenes y piensan, sino que empiezan a aprender, las posibilidades de automatización de los trabajos podrían ampliarse hasta límites inimaginables. Pero, si las máquinas desempeñan nuestro trabajo, ¿qué haremos nosotros? Este es el miedo de muchos trabajadores y de no pocos economistas. Sin embargo, lo que algunos entienden como una amenaza, otros lo perciben como una oportunidad. Un contraste de visiones que se repite cada vez que un cambio tecnológico sacude el statu quo de nuestra sociedad.

La automatización puede afectar al empleo a través de distintas vías. En general, aquellos que temen que las máquinas puedan reemplazarnos en el trabajo se basan en el llamado «efecto sustitución». Porque la automatización fue, es y será un claro sustituto de numerosos puestos de trabajo, lo que comporta la destrucción de empleo en ciertos sectores y ocupaciones. Así, a principios del siglo XX, algo más del 40% de la fuerza laboral estadounidense estaba empleada en el sector agrícola, lejos del 2% actual. Sin embargo, EE. UU. sigue siendo uno de los principales productores y exportadores de productos agrícolas en el mundo y su tasa de paro se sitúa en un muy bajo 5%.

A pesar de las similitudes que podemos encontrar entre la situación actual y lo ocurrido en el pasado, hay varios factores que sugieren que el ciclo que estamos viviendo es distinto. La explotación del big data y los avances en la tecnología visual y del reconocimiento del lenguaje pueden suponer una auténtica revolución en el desarrollo de la inteligencia artificial. Una Cuarta Revolución Industrial, como ya se empieza a denominar. Una máquina, en un futuro no muy lejano, podría ejercer de taxista o de radiólogo. Según un informe reciente de la consultora McKinsey, la actual revolución tendría la capacidad de sustituir el 45% de las tareas que realizan los trabajadores en la actualidad. Un porcentaje que, aun así, se acerca a la reducción del 40% al 2% en el sector agrícola estadounidense comentada más arriba (véase «¿Llegará la Cuarta Revolución Industrial a España?» en este mismo Dossier, para más detalles sobre los distintos estudios que tratan la cuestión y para un análisis elaborado del caso español).

Además del efecto sustitución, existe también el efecto complementariedad. Hay puestos de trabajo en los que la automatización complementa al trabajador. En estos casos, de hecho, las máquinas incrementan la productividad de los trabajadores, lo que repercute también en un aumento de su remuneración. Más allá de estos dos efectos (sustitución y complementariedad), lo que los críticos a la automatización suelen obviar es que la innovación tecnológica expande la frontera de producción: con los mismos recursos se puede producir más (crece el PIB o el tamaño del pastel, o renta, para repartir). De esta manera, el nivel de actividad económica aumenta claramente si los recursos que las nuevas tecnologías liberan se utilizan para realizar otras tareas y producir otros bienes y servicios (que pueden tener que ver o no con la tecnología desarrollada). Este es el análisis que efectúan economistas como David Autor, del Massachusetts Institute of Technology, y que atenúan los temores a la nueva era de máquinas inteligentes. Al fin y al cabo, dice en uno de sus artículos, «los dos últimos siglos de automatización y progreso tecnológico no han hecho obsoleto al trabajador».1 Es más, la Revolución Industrial (1760-1840) trajo consigo el crecimiento económico en mayúsculas.2

Aunque las virtudes a largo plazo de la Revolución Industrial son evidentes, a corto plazo no todo el mundo ganó con el cambio. Obviamente, los primeros perjudicados fueron el conjunto de trabajadores que perdieron el empleo sustituidos por las nuevas máquinas. Además, los trabajadores que no perdieron el empleo no vieron aumentar su salario real durante décadas, aunque su productividad mejorara sustancialmente (véase el gráfico que recoge el lento avance de los salarios entre 1800 y 1860).3 Por otro lado, tampoco aumentaron los salarios de los trabajadores con mayores conocimientos técnicos, a pesar de la ventaja que representaban tales conocimientos durante la época de la industrialización (el efecto wage skill premium, en su voz inglesa).4

Joel Mokyr, experto en historia económica de la universidad norteamericana de Northwestern, ofrece como una posible explicación a la falta de traslación de las mejoras de productividad en los salarios el papel de las instituciones.5Menciona, por ejemplo, tradiciones como la obligación de los campesinos de hacer uso del molino del señor o el propio sistema mercantilista como prácticas que permitían que unos pocos capturaran las rentas generadas mediante el progreso tecnológico. En este sentido, destaca cómo las reformas institucionales, que permitieron la desaparición de los monopolios y los privilegios que frenaban la competencia, proporcionaron el entorno adecuado para una mejor distribución de las rentas y para asegurar progresos tecnológicos sostenidos.

El descenso de la participación del factor trabajo en la renta (frente al factor capital) en la mayoría de países avanzados durante las últimas décadas se esgrime como prueba del impacto en el mercado de trabajo de los avances tecnológicos actuales, así como de la necesidad de cambios institucionales que frenen esta tendencia (véase el artículo «¿Cómo aprovechar el impacto positivo del cambio tecnológico en el empleo?» en este mismo Dossier, para saber más sobre las actuaciones institucionales que se proponen ante la revolución actual). Sin embargo, es importante comentar que no solo la tecnología puede haber provocado esta disminución. Entre otros elementos, destaca la globalización (con la entrada de trabajadores procedentes de los países pobres en el mercado laboral de los ricos a través del comercio y del offshoring) o la pérdida de poder de los sindicatos.6

El efecto de la automatización sobre la polarización de los salarios de los trabajadores, en cambio, sí parece ser un fenómeno sobre el cual existe mayor consenso entre los expertos. El hecho de que los nuevos robots sean capaces de sustituir a un perfil de profesionales con conocimientos intermedios y salarios medios podría ser un factor importante que explique el aumento de dicha polarización. Con todo, en este aspecto, elementos como la globalización entran de nuevo en escena causando el mismo tipo de dicotomía.

En suma, es complejo predecir los efectos que tendrán las máquinas del futuro sobre el trabajo tal y como lo entendemos hoy en día. Pero parece probable que, si los creamos, los C-3PO y los R2-D2 del mañana tengan como objetivo hacernos la vida más cómoda. Aun así, los ajustes en el proceso de mejora global pueden ser importantes para los trabajadores más directamente afectados por la competencia de las máquinas que puedan hacer su trabajo. Por este motivo, son necesarias unas instituciones que favorezcan el desarrollo tecnológico sin olvidarse de las personas que puedan resultar más perjudicadas a corto plazo.

Clàudia Canals

Departamento de Macroeconomía, Área de Planificación Estratégica y Estudios, CaixaBank

1. Véase Autor, D. H. (2015), «Why are there still so many jobs? The history and future of workplace automation». The Journal of Economic Perspectives 29, no. 3 (2015): 3-30.

2. A partir de la Revolución Industrial se produjeron avances significativos en el PIB per cápita, según estimaciones de Angus Maddison.

3. Véase Allen, R. C. (2009), «Engels' pause: Technical change, capital accumulation, and inequality in the british industrial revolution». Explorations in Economic History, 46(4), 418-435.

4. Véase Mokyr, J. (2005), «Long-term economic growth and the history of technology». Handbook of economic growth, 1, 1113-1180.

5. Íbid.

6. Véase CaixaBank Research (2014), «Las rentas del trabajo en perspectiva», Dossier del Informe Mensual de febrero de 2014.

↧

Horarios en España, desfasados e improductivos

↧

↧

La comuna paradisíaca de los abuelos

La comuna paradisíaca de los abuelos

Han decidido abordar la etapa final de su vida de un modo satisfactorio. No quieren languidecer pasivamente con una vejez melancólica, ser una carga para sus hijos o ingresar en una residencia de mayores al uso. Pretenden que el ocaso de sus días sea un periodo activo, nutritivo, jovial, de crecimiento humano y bienestar.

Por ello han fabricado su particular paraíso: Trabensol(Trabajadores en Solidaridad), una comunidad de individuos, con diferentes criterios e ideologías, que han invertido los ahorros de toda una vida en un proyecto que les permite convivir bajo una fórmula cooperativa única en nuestro país.

Todo comenzó hace 14 años cuando, un grupo de amigos a punto de jubilarse y con una intensa actividad social a sus espaldas, cayeron en la cuenta de que se estaban haciendo mayores.

«Queríamos alternativas diferentes a las que habían vivido nuestros padres. Tras muchas horas de diálogos y debates, decidimos constituir una cooperativa y levantar un centro de convivencia para mayores en el que pudiéramos vivir una vejez saludable, ser independientes, ayudarnos entre nosotros y organizarnos gracias a comisiones de trabajo que nos hicieran responsables del funcionamiento del colectivo», explica Paloma Rodríguez, presidenta de la cooperativa, que comparte habitación con su vecina de hace 40 años. «Nos quedamos viudas y decidimos emprender esta aventura juntas. Aquí estamos estupendamente. Es fantástico vivir bajos los lazos de la comprensión y el cariño».

Agotadora búsqueda

A partir de ahí comenzó una agotadora búsqueda para encontrar el terreno adecuado en el que realizar el proyecto. «Visitamos muchos lugares y, desgraciadamente, vivimos de cerca lo que se mueve en el negocio inmobiliario, fueron muchos los ayuntamientos que quisieron engañarnos. Finalmente apareció Carlos Rivera, alcalde de Torremocha del Jarama, que nos tendió la mano sin intereses ocultos, pagos ni intermediarios, afirmando que Trabensol iba a aportar al pueblo una riqueza enorme y un gran potencial mental y social», apunta José María García, ex secretario de consistorios.

Al pie de la sierra, en una vega llana y fértil, junto a la orilla del río, se erige el colorido complejo de 16.000 metros cuadrados, construido de forma bioclimática por filtración y geotermia, una energía limpia, renovable y económica, que les permite hasta un 75% de ahorro mensual.

«Está todo muy pensado. Las zonas de acceso de la casa están orientadas al norte y las del alojamiento al sur. Tenemos 25 pozos de 150 metros que hacen que el suelo sea radiante y tenga una temperatura constante de 16 grados. Los canalones de los tejados van a un aljibe que recoge el agua de la lluvia y nos permite regar durante tres meses. Los aislamientos térmicos y acústicos están muy cuidados y las luces exteriores están dirigidas hacia abajo para que no haya contaminación lumínica y podamos ver las estrellas», señala Jaime Moreno, periodista y coordinador de la comisión de comunicación del lugar.

Un hogar, no un geriátrico

Con la férrea intención de edificar un hogar alejado del concepto actual de las residencias de mayores, el complejo, exquisitamente decorado, está preparado para armonizar la cohabitación en común con la vida independiente. Circundando un huerto de 10.000 m2, tranquilos patios y aromáticos jardines, se encuentran las 54 viviendas de los afiliados, 50m2 repartidos entre una cocina americana, un salón, una habitación, un baño geriátrico y una terraza. «Mi anterior casa tenía el doble de metros, estaba harta de trabajar tanto en ella. Esta es muy apañada, cubre todas mis necesidades», afirma María Dolores Hernández, ex enfermera. Su amiga Luisa Llorena, ex dinamizadora social, dice:«Quería llegar aquí como una libélula, ligera de equipaje. Mi marido y yo hemos traído sólo los muebles que han cabido, ha sido un ejercicio de liberación de apegos del pasado. Ahora, nuestra vida cabe en 50 m2», sonríe.

El lugar cuenta con un amplio abanico de zonas comunes en las que disfrutar del momento: biblioteca, hemeroteca, gimnasio, un mini spa de baños terapéuticos, salas de reiki, de acupuntura, de música, de pintura o de edición de video, un claustro zen para pasear cuando hace mal tiempo, un habitáculo con juguetes para que los nietos gocen con los abuelos, salones de reunión para celebrar fiestas o el salón del silencio. «Aquí hay gente que es religiosa y hemos considerado que era necesario crear un espacio común y polivalente para meditar, rezar o practicar yoga. En Berlín van a hacer un centro donde diferentes religiones van a compartir techo, nosotros ya lo estamos haciendo», señala Jaime.

Mayores de alma joven

Como bien apunta Pepa Salamanca, ex auxiliar de clínica, «en Trabensol el mayor valor, sin duda, es el potencial humano». La convivencia entre los residentes, en su mayoría gente muy preparada, es plenamente activa y cada uno pone a disposición de la comunidad su experiencia profesional. «Vivimos en un clima de tolerancia y ayuda mutua», cuenta María Dolores. «Tenemos talleres de danzas del mundo, Ikebana, vidriado, costura, pintura, Chi Kung o bricolaje y hacemos nuestra propia gaceta informativa interna». Carmela Paz, ex administrativa del Instituto Cervantes asiente: «Es un lugar agradable para vivir. Conoces gente fantástica y haces cosas que te mantienen activa física y mentalmente. Además el entorno es fantástico, mientras que en Madrid te desplazabas a los barrios, aquí te desplazas a los pueblos». José María apostilla: «¡No paramos, cada día hay algo nuevo! Estamos en una adolescencia de la vejez. Mis hijas nos dicen que estamos haciendo la comuna que no pudimos en los 60», bromea.

En la comida todos colaboran en los quehaceres del inmenso comedor que tiene como chef a Mina Tartili, miembro de la asociación Ananda. «Trabajar aquí es gratificante. El ambiente es increíble, hacen todo lo posible por mantener un clima de alegría y solidaridad.Son mayores de alma joven, sabias y con una conciencia social que engancha».

¿Y si llegan momentos de dificultad física o de enfermedad? Jaime explica que están preparados para todo lo que venga. «Hay vigilancia las 24 horas. El complejo está habilitado para personas con movilidad reducida. En cada pasillo hay varios baños, por si hay urgencias, en cada esquina un ascensor con el tamaño suficiente para una silla de ruedas y tenemos un ala, especialmente habilitada, para personas que necesiten cuidados médicos específicos. Queremos pasar nuestros últimos días aquí de la mejor forma posible».

Un CoHousing español con lista de espera

Este sistema de vivienda colaborativa, diseñado y gobernado por los propios residentes, nació en Dinamarca, a finales de los años 60, y se extendió a Norte América, a finales de los 80, bajo la pretensión de volver al sentido de comunidad primigenio de los barrios de antaño. "Trabensol ha sorprendido mucho en Europa. Nosotros informamos, con toda libertad, a quienes nos preguntan sobre cómo hemos llegado hasta aquí, pero lo imprescindible es que haya un núcleo humano suficientemente fuerte y comprometido para poder llevar algo así a cabo.", explica Moreno. Son tantos los interesados en esta particular forma de vida que ya cuentan con una nutrida lista de espera. ¿Los requisitos? Tener entre 50 y 70 años, identificarse con los principios básicos de solidaridad y ayuda mutua, y tener solvencia económica para mantener los pagos: una inversión inicial de 154.000 y hasta 1100 al mes. "Incluye alojamiento, lavandería, limpieza y la comida del medio día. Somos de una generación en la que se compraban pisos porque no había casi alquileres. Los hemos vendido para poder afrontar el coste del proyecto. Tenemos una acción pero la propiedad es de la cooperativa. Quien decida marcharse recupera el dinero, al valor que tenga en ese momento, y morimos lo recuperan nuestros herederos, que también pueden, si cumplen los requisitos y quieren, venir a vivir aquí.

↧

La línea que separa el éxito del fracaso de un país.entrevista:James A. Robinson

"La renta básica es buena idea, es simplista pensar que la gente no trabajará"

El autor de uno de los libros de economía más importantes de la última década nos explica dónde se encuentra la línea que separa el éxito del fracaso de un país

↧

Dando la talla: Antropometría, crecimiento económico y desigualdad FRAN BELTRÁN el 30/03/2016

Uno de los objetivos principales de la historia económica consiste en indagar en la evolución histórica de los niveles de vida. Aunque lo más frecuente en este sentido es recabar información sobre producción per cápita o salarios, estos indicadores no tienen en cuenta los beneficios o costes del contexto en el que se vive o la producción y la distribución que tiene lugar fuera del mercado, limitaciones que son especialmente relevantes en el pasado. La historia antropométrica ha supuesto una gran contribución a estos temas ya que captura aspectos esenciales del bienestar humano (un resumen de la literatura aquí y aquí).

http://nadaesgratis.es/fran-beltran/dando-la-talla-antropometria-crecimiento-economico-y-desigualdad

Una parte muy importante de esta literatura se centra en la estatura. Aparte del componente genético, la talla adulta refleja lo que se conoce como nutrición neta durante la infancia y la adolescencia. La nutrición neta no sólo tiene en cuenta los aportes alimenticios, sino también lo que el cuerpo consume: tanto el trabajo físico como la lucha contra las enfermedades reduce la energía disponible. Cuando la nutrición neta es crónicamente inadecuada, la estatura se resiente porque el cuerpo da prioridad a la supervivencia frente al crecimiento. Entre 1870 y 1980, la estatura de los hombres en Europa occidental creció alrededor de 11 centímetros, un hecho sin precedente en el registro histórico (aquí o aquí). Este avance está claramente relacionado con el crecimiento económico que estas sociedades han experimentado, lo que les ha permitido mejorar su alimentación y, especialmente, su salud. Los avances médicos y las mejoras en salud e higiene pública han sido especialmente importantes, lo que resalta el papel del estado a la hora de mejorar las condiciones ambientales y reducir la incidencia de las enfermedades.

Pero una de las aportaciones más importantes de la historia antropométrica ha consistido en evidenciar que incrementos en la renta no siempre se trasladan en mejoras en la estatura. Los historiadores han explotado a conciencia los archivos de instituciones que medían regularmente a la gente, especialmente registros militares y de prisiones, y han amasado literalmente miles de observaciones individuales, contribuyendo de forma crucial a estos debates. Estas fuentes de datos están lejos desde luego de ser perfectas: no sólo el ejército solía imponer estaturas mínimas de acceso, sino que los reclutas son una muestra seleccionada de la población general (a no ser que el reclutamiento sea universal). A esto hay que añadir que estas muestran se limitan en su mayoría a hombres.

En una obra clave, Floud, Wachter and Gregory recopilaron los datos de más de cien mil reclutas británicos. Deborah Oxley y David Meredith han ajustado alguno de los problemas que tenía la serie original y han reconstruido la talla media británica entre 1733 y 1870. Estos resultados han aparecido recientemente en Past & Present y Deb Oxley me ha proporcionado amablemente sus datos para poder ilustrar esta entrada (recomiendo también ver el video de la magistral Tawney Lecture que impartió en 2013). El siguiente gráfico contrapone la evolución de la estatura con la de la renta per cápita: a pesar del fuerte crecimiento económico que la industrialización estaba generando, la estatura media se redujo significativamente entre 1815 y 1850. La talla sólo empezó a aumentar de forma sistemática a partir de 1860 conectando con el crecimiento sin precedentes que ocurrió desde entonces y que comentábamos arriba. Aunque aquí nos centramos en la experiencia británica, hay que decir que estudios para otros países encuentran resultados similares (aquí).

Fig. 1. Evolución de las estatura en Gran Bretaña, 1733-1870

La mejora de la renta no se reflejó en mejoras generales de bienestar porque otros factores actuaron en sentido contrario. En este sentido, hay que tener en cuenta el incremento de la desigualdad, el aumento de las horas de trabajo y cómo el crecimiento económico se trasladaba a los salarios reales. Asimismo, es muy importante considerar que las pésimas condiciones existentes en los centros urbanos e industriales se tomaron un peaje importante en términos de salud. Aunque el campo de los “pesimistas” ha acumulado bastante evidencia en este sentido, los “optimistas” alegan que inferencias obtenidas de muestras tan seleccionadas no serían validas.

Otra gran aportación de la historia antropométrica es en el terreno de la desigualdad. Las diferencias de clase se reflejan claramente en la talla: en el siglo XVIII, por ejemplo, la diferencia media de estatura a los 14 años entre los chicos pobres y los de clase alta que entraban en diversos cuerpos del ejército era de 22 centímetros! Junto a los datos militares anteriores, la siguiente figura incorpora las estaturas de miles de reclusos registrados en prisiones en Wandsworth (W) y Bedford (B), además de convictos transportados a Australia (A). Este gráfico no sólo evidencia la brecha en el nivel de vida entre distintas clases sociales, sino que confirma que el declive o estancamiento de la talla no fue una tendencia exclusiva propia de los datos militares.

Fig. 2. Evolución de la estatura en Gran Bretaña. Distintas muestras

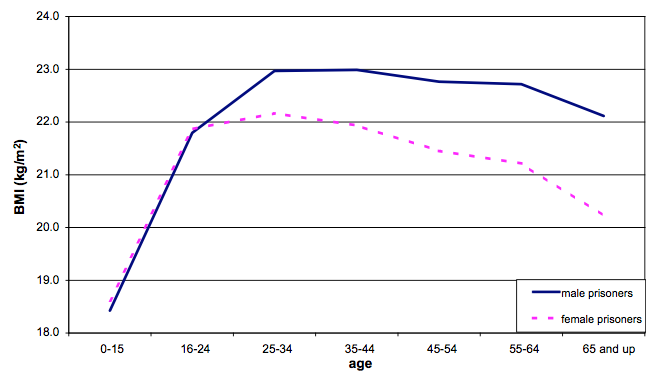

Pero quizás el área donde la historia antropométrica está dando más frutos es en la medición de la desigualdad de género dentro del hogar. Por su propia naturaleza privada, es muy difícil saber lo que pasa dentro de las familias, especialmente en lo que respecta a la distribución de recursos y trabajo. Algunos autores se han aprovechado de este tipo de datos para ofrecer perspectivas muy clarificadoras de lo que podía estar ocurriendo. Aunque la población reclusa femenina era menos numerosa, Sara Horrell, David Meredith y Deb Oxley han amasado información no sólo de su estatura, sino también de su peso. Con estos datos han podido calcular el Índice de Masa Corporal (BMI en inglés) que es un indicador que, a diferencia de la estatura adulta, permite ver cómo evoluciona el estado nutricional neto a lo largo del ciclo vital (aquí y aquí).

El siguiente gráfico (sacado de sus publicaciones) compara los Índices medios de Masa Corporal para distintos grupos de edad de miles de reclusos y reclusas admitidos en el Correccional de Wandsworth (Surrey) entre 1858 y 1878. En él se observa que, aunque los volúmenes corporales de hombres y mujeres crecían de forma similar hasta alcanzar el inicio de la veintena, a partir de esa edad se abría una brecha creciente conforme las mujeres se casaban, empezaban a tener hijos y el tamaño de la familia aumentaba.

Fig 3. Índice de Masa Corporal. Reclusos de Wandsworth, 1858-1878

Fuente: Horrell et al. (2009, 110).

Fuente: Horrell et al. (2009, 110).Los autores argumentan que estos datos indican que la distribución de los recursos dentro del hogar penalizaba claramente a las mujeres casadas y con hijos, lo que era un reflejo de su escaso poder de negociación en una sociedad en el que las oportunidades abiertas a estas mujeres eran escasas. A diferencia de los reclusos masculinos, muchas de estas mujeres de hecho ganaban peso en prisión (y no es que las raciones de las prisiones victorianas fueran muy generosas!). Esta visión del hogar concuerda muy bien con la evidencia que Jane Humphries ha obtenido analizando cientos de autobiografías de hombres y mujeres de la clase obrera durante este período (hace un mes presentó un magnífico resumen de sus trabajos recientes en las Ellen McArthur Lectures en Cambridge).

Aunque esto sólo es una muestra muy pequeña de todo el trabajo que se está haciendo, espero que esta entrada haya permitido ver que la historia antropométrica está jugando un papel muy importante en nuestro entendimiento de los niveles de vida en el pasado, y promete seguir haciéndolo en los próximos años.

↧

Aprendizaje profundo Fernandez-Villaverde

Aprendizaje profundo I

El martes pasado concluía en Seúl la quinta y final partida de go(wéiqí en Chino) entre Lee Sedol, quizás el jugador actual más competitivo, y AlphaGo, un programa desarrollado por Google DeepMind, una subsidiaria de Google especializada en inteligencia artificial. El resultado final, 4-1, fue una victoria rotunda de la maquina sobre el ser humano.Aunque mis habilidades con go, habiendo llegado al juego ya muy mayor, son prácticamente inexistentes, en mi familia hay varios jugadores apasionados del mismo que han dedicado, siguiendo una tradición milenaria en China, muchos años (algunos incluso décadas) al estudio de este arte (algo ahora facilitado por lasmuchas apps existentes para el iPad). Es natural, pues, que siguiésemos las cinco partidas con interés inusitado (incluyendo el parar en medio de Hyde Park en Londres para comprobar en el iPhone los últimos movimientos de cada jugador).En comparación con el ajedrez o las damas, y a pesar de tener unas reglas a primera vista muy sencillas, go es un juego que genera muchas más combinaciones posibles de movimientos. El numero total de partidas legales de go se calcula en torno a mientras que el numero de partidas legales en ajedrez es “solo” de y en damas de un casi trivial . Esta diferencia de 50/150 órdenes de magnitud implica que el enfoque de “fuerza bruta” (literalmente, comprobar muchísimas jugadas posibles y seleccionar aquellas que maximicen el valor de la posición de las piezas en el tablero después de varias rondas de movimientos) que está en el centro del los programas tradicionales de ajedrez o de damas resulte de menos utilidad en el juego asiático.

Como consecuencia principal, un programa competitivo de go al mayor nivel tiene que diseñarse con un enfoque alternativo basado en inteligencia artificial; es decir, ha de ser un programa que de alguna manera “entienda” cómo está jugando más que simplemente comprobar todas (o casi todas) las posibilidades existentes gracias a su potencia computacional y seleccionar la mejor entre ellas.[1] Incluso entre los seres humanos, la intuición, el estilo personal y la imitación de los grandes maestros del pasado tiene mucho más importancia en go que en ajedrez; lo cual también explica porque el pico de calidad de los jugadores profesionales en go a menudo llega muy pronto en su carrera y que se puedan escribir novelas como El Maestro de Go, deYasunari Kawabata.Y aunque muchos observadores conjeturaban que tal programa de go llegaría tarde o temprano, ha causado cierta sorpresa que haya sido en 2016. Elon Musk (el CEO de Tesla y un buen conocedor el mundo de la alta tecnología) ha citado un adelanto de diez años sobre las predicciones existentes. Tan recientemente como 2015, los mejores programas de go solo alcanzaban al nivel de un amateur sofisticado pero no podían competir con jugadores profesionales. AlphaGo, aplicando técnicas de aprendizaje profundo (en inglés, deep learning) se ha saltado esos 10 años y nos ha dejado a todos un pelín descolocados (aunque también ha habido voces escépticas sobre la generalidad de la contribución, como en este artículo de Gary Marcus).En mi caso personal, el interés por el encuentro entre Lee Sedol y AlphaGo se reforzaba por la observación de que llevo un año trabajando en la aplicación en economía de algoritmos de aprendizaje automático (en inglés, machine learning), que incluyen los algoritmos de aprendizaje profundo como un subconjunto importante de los mismos. Y dado que este miércoles tengo que hablar sobre aprendizaje automático en economía (lo siento, no es una charla pública y no tengo transparencias que pueda circular), escribir una serie de dos entradas en NeG sobre los mismos me sirve para pulir la introducción a la misma. Dada la extensión del material a cubrir, hoy hablaré sobre el aprendizaje automático más en general y la semana que viene sobre el aprendizaje profundo que esta detrás de AlphaGo.El aprendizaje automático es un conjunto de algoritmos diseñados para permitir que un código de ordenador aprenda sobre patrones en los datos. En vez de especificar una larga lista de atributos de los objetos a estudiar (como hacían los sistemas expertos antiguos), los algoritmos de aprendizaje automático comienzan con un simple modelo del mundo para clasificar observaciones y una serie de reglas para modificar tal modelo según el éxito del mismo. Dado que la mayoría de los ejemplos en los libros y en internet no son de economía y que los lectores de este blog podrán, llegados a este momento, estar preguntándose qué tiene todo esto que ver con nuestro campo de investigación, déjenme que les de un ejemplo. De hecho este ejemplo es el que empleo en mi propio trabajo.Imaginémonos que disponemos de una base de datos muy amplia de la estructura financiera de empresas, como Compustat. Esta base de datos nos suministra información sobre el capital, deuda, bonos, ventas, crecimiento, etc. de un amplio abanico de empresas a lo largo de varias décadas. La cantidad de información en la misma es tremenda. El procedimiento tradicional de los economistas para analizar empíricamente tal información se ha basado en dos líneas de ataque.Una primera línea de ataqueLa primera línea de ataque, a veces llamada de forma reducida, busca especificar regresiones entre distintas variables observadas basándose en una mezcla de intuición y ligera teoría. Por ejemplo, el investigador regresa el apalancamiento de la empresa contra su tasa de crecimiento o la industria en la que opera. La idea es que, por ejemplo, si una empresa crece deprisa es probable que quiera apalancarse para aprovechar las oportunidades y financiar tal crecimiento. Este bien citado trabajo de Murray Frank y Vidhan Goyal es un ejemplo representativo de esta estrategia empírica.Las desventajas de esta estrategia empírica son obvias. Solo por citar un problema entre muchos otros, uno nunca sabe hasta que punto los patrones documentados en los datos son espurios, producto quizás del azar, del prolongado esfuerzo del investigador de corroborar sus preconcepciones o del sesgo de publicación (es mucho más fácil publicar resultados positivos que negativos). Buena parte del esfuerzo de la econometría actual es buscar criterios de credibilidad basados en un análisis explícito de las fuentes de la identificación que permitan solventar estas dudas con un grado razonable de confianza.Pero incluso olvidándonos de estos problemas, nos queda siempre la inquietud de que, con bases de datos amplias, incluso el investigador más perspicaz puede perderse y no descubrir patrones empíricos interesantes. Cualquiera que haya corrido regresiones complejas y presentado las mismas en público ha sufrido la experiencia de ver como un miembro de la audiencia levanta la mano y le pregunta “¿has probado x?” y pensar para uno mismo: “¿cómo no se me ha ocurrido a mi tan obvia pregunta?” Con la llegada de bases de datos masivas (en inglés, big data) este problema de mero manejo de los datos se hace cada vez más agudo, en especial en aplicaciones industriales, donde se necesitan calcular millones de regresiones con miles de potenciales regresores de manera cotidiana.Un algoritmo de aprendizaje automático intenta explorar esta base de datos y buscar patrones empíricos robustos. En vez, por ejemplo, de probar todas y cada una de las especificaciones de regresión posibles (un problema de complejidad exponencial), podemos construir sencillos programas que encuentren relaciones en los datos y emplear las mismas para entender nuestra base de datos y predecir comportamientos futuros.En una entrada de este blog, no puedo más que arañar la superficie de estos algoritmos, pero el libro de texto más popular sobre el tema es este de Kevin P. Murphy. Es un manual amplio, detallado y fácil de seguir. De todas maneras, y solo por ser un poco más concreto, voy a explicar la idea básica detrás de una búsqueda voraz (greedy search en inglés), un algoritmo de aprendizaje automático muy extendido y sencillo de programar.Imaginemos que comenzamos construyendo una regresión

-regularizada del apalancamiento de una empresa contra un conjunto de variables observadas como su tasa de crecimiento, el sector en el que opera o las características de su gobernanza corporativa. La regularización nos permite penalizar aquellas especificaciones que sobre-ajustan los datos. Las variables observadas pueden ser seleccionadas aleatoriamente (si que queremos un algoritmo totalmente automático) o con unas suposiciones rápidas previas (en inglés, an educated guess). De hecho, podemos comenzar incluso con un conjunto vacío de regresores, lo que facilita la generalización del algoritmo a problemas donde tiene que ser implementado miles de veces.

Una vez estimada la primera regresión

-regularizada (o si estamos empleando un conjunto vacío, después de inicializar el programa), seleccionamos aleatoriamente una variable de las no incluidas entre los regresores para ser incluida en la segunda regresión y seleccionamos, de nuevo de manera aleatoria, una variable incluida en la primera regresión (excepto cuando comenzamos con el conjunto vacío) para ser eliminada. La selección aleatoria puede realizarse con una probabilidad positiva de no movimiento (es decir de no eliminar una variable ya existente o de no incluir una nueva variable), para que el número total de regresores sea, en si mismo, una variable aleatoria. Una vez realizado este remplazo, estimamos la nueva regresión y comprobamos una medida de ajuste a los datos. Medidas populares incluyen el nivel de la verosimilitud marginal o, en el caso de que tal verosimilitud marginal sea costosa de computar, la moda de la distribución a posteriori del modelo (este tipo de algoritmos se suelen anidar en algún tipo de Monte Carlo por Cadenas de Markov). El algoritmo puede continuar iterando en las regresiones regularizadas hasta que no se aprecien mejoras en el ajuste del modelo a los datos.

La experiencia de correr esta clase de algoritmos nos suele demostrar dos lecciones. Primero, que el ajuste va a “saltos”. En muchas iteraciones apenas avanzamos: el algoritmo parece estancado. Y, de repente, un pequeño cambio en el conjunto de regresores, trae consigo una mejora sustancial que es seguida en las siguientes iteraciones por otras mejoras importantes, antes de volverse de nuevo a estabilizar. Aquellos lectores con conocimientos de evolución reconocerán en este patrón un caso de equilibrios puntuados como los propuestos por Niles Eldredge y Stephen Jay Gould (no voy a discutir, pues no es mi campo si tales equilibrios puntuados existen o no en biología evolutiva; solo resalto que en optimización aleatoria tales equilibrios puntuados se ven todo el rato).Segundo, que el resultado final a veces es increíblemente contra-intuitivo: los regresores que importan para ajustar los datos no son los que uno hubiese pensado. No voy a entrar en la interpretación de si estos regresores tienen o no sentido económico o de si esto ayuda a “entender” el mundo. Lo que si que conozco con 100% certeza (y aquí estoy sujeto a “non-disclosure agreements” con fuerza legal, así que he de ser deliberadamente ambiguo) es que muchas empresas han descubierto que tales regresiones aleatorias les sirven para predecir francamente bien la cantidad de unidades de un bien que necesitan almacenar en sus diferentes centros de distribución incluso cuando la regresión parece no “tener sentido” alguno. Y muchos jugadores de go pensaron que algunos de los movimientos de AlphaGo eran totalmente contra-intuitivos en tiempo real y, sin embargo, al final del día tenían mucho sentido. En otras palabras, la búsqueda aleatorizada nos hace descubrir regiones de configuraciones de la regresión o de comportamiento que no habríamos explorado de otra manera.Una segunda línea de ataqueMencionaba anteriormente que frente a la técnica de formas reducidas, existía una segunda línea de ataque de los economistas a los problemas empíricos (y una línea en la que yo he trabajado mucho más): el enfoque estructural. Este enfoque plantea un modelo económico explícito y, en vez de estimar regresiones, estima los parámetros que indician tal modelo (por ejemplo, los parámetros estructurales de la función de utilidad, funciones de producción o conjuntos de información). No es este el momento de repasar los argumentos a favor o en contra de este segundo enfoque. Solo apuntar rápido que los algoritmos de aprendizaje automático también tienen un papel que jugar en esta clase de enfoques, en particular en la solución de problemas de optimización de alta dimensionalidad en el corazón de los mismos (esto es, en concreto, el problema en el que estoy trabajando ahora mismo; bueno, en cuanto acabe de colgar esta entrada).A modo de conclusión rápidaNo soy, ni muchísimo menos, el primer economista en trabajar en estos temas. Susan Athey lleva años trabajando en cosas similares (aunque desde un enfoque distinto del mío). Aquí, por ejemplo, Athey discute varias de las ideas del campo y aquí, con Guido Imbens, dando unas clases magistrales sobre el tema.En el otoño tengo programadas unas clases sobre aprendizaje automático. Si tengo tiempo de preparar unas transparencias con las que esté contento y

AlphaGo Skynet no nos ha convertido en sus esclavos, las colgaré en internet y las anunciaré aquí en NeG. Mientras tanto y en espera de la segunda entrada de esta serie el martes que viene, como dice una máquina de aprendizaje automático: “hasta la vista, baby!”1. Los programas de ajedrez o de damas no son particularmente intrigantes desde el punto de vista de inteligencia artificial: aunque incorporan ideas interesantes de como evaluar posiciones en el tablero o de como simplificar la búsqueda de movimientos eliminando ramas del árbol de decisión de manera temprana, como reitero en el texto principal, al final del día se centran en la aplicación de fuerza bruta computacional. La victoria de DeepBlue sobre Kasparov en 1997, mientras que prueba significativa del avance en la velocidad de procesamiento, no era un cambio cualitativa en la capacidad de los ordenadores de descubrir estrategias de comportamiento óptimo. De igual manera que un ordenador puede calcular muchísimo más rápido que cualquier humano, un ordenador moderno puede evaluar muchos más movimientos de ajedrez, pero en cierto sentido no hay “mayor secreto” en ello.{ 19 comentarios… léelos a continuación añade uno }![]()

El martes pasado concluía en Seúl la quinta y final partida de go(wéiqí en Chino) entre Lee Sedol, quizás el jugador actual más competitivo, y AlphaGo, un programa desarrollado por Google DeepMind, una subsidiaria de Google especializada en inteligencia artificial. El resultado final, 4-1, fue una victoria rotunda de la maquina sobre el ser humano.

Aunque mis habilidades con go, habiendo llegado al juego ya muy mayor, son prácticamente inexistentes, en mi familia hay varios jugadores apasionados del mismo que han dedicado, siguiendo una tradición milenaria en China, muchos años (algunos incluso décadas) al estudio de este arte (algo ahora facilitado por lasmuchas apps existentes para el iPad). Es natural, pues, que siguiésemos las cinco partidas con interés inusitado (incluyendo el parar en medio de Hyde Park en Londres para comprobar en el iPhone los últimos movimientos de cada jugador).

En comparación con el ajedrez o las damas, y a pesar de tener unas reglas a primera vista muy sencillas, go es un juego que genera muchas más combinaciones posibles de movimientos. El numero total de partidas legales de go se calcula en torno a mientras que el numero de partidas legales en ajedrez es “solo” de y en damas de un casi trivial . Esta diferencia de 50/150 órdenes de magnitud implica que el enfoque de “fuerza bruta” (literalmente, comprobar muchísimas jugadas posibles y seleccionar aquellas que maximicen el valor de la posición de las piezas en el tablero después de varias rondas de movimientos) que está en el centro del los programas tradicionales de ajedrez o de damas resulte de menos utilidad en el juego asiático.

Como consecuencia principal, un programa competitivo de go al mayor nivel tiene que diseñarse con un enfoque alternativo basado en inteligencia artificial; es decir, ha de ser un programa que de alguna manera “entienda” cómo está jugando más que simplemente comprobar todas (o casi todas) las posibilidades existentes gracias a su potencia computacional y seleccionar la mejor entre ellas.[1] Incluso entre los seres humanos, la intuición, el estilo personal y la imitación de los grandes maestros del pasado tiene mucho más importancia en go que en ajedrez; lo cual también explica porque el pico de calidad de los jugadores profesionales en go a menudo llega muy pronto en su carrera y que se puedan escribir novelas como El Maestro de Go, deYasunari Kawabata.

Y aunque muchos observadores conjeturaban que tal programa de go llegaría tarde o temprano, ha causado cierta sorpresa que haya sido en 2016. Elon Musk (el CEO de Tesla y un buen conocedor el mundo de la alta tecnología) ha citado un adelanto de diez años sobre las predicciones existentes. Tan recientemente como 2015, los mejores programas de go solo alcanzaban al nivel de un amateur sofisticado pero no podían competir con jugadores profesionales. AlphaGo, aplicando técnicas de aprendizaje profundo (en inglés, deep learning) se ha saltado esos 10 años y nos ha dejado a todos un pelín descolocados (aunque también ha habido voces escépticas sobre la generalidad de la contribución, como en este artículo de Gary Marcus).

En mi caso personal, el interés por el encuentro entre Lee Sedol y AlphaGo se reforzaba por la observación de que llevo un año trabajando en la aplicación en economía de algoritmos de aprendizaje automático (en inglés, machine learning), que incluyen los algoritmos de aprendizaje profundo como un subconjunto importante de los mismos. Y dado que este miércoles tengo que hablar sobre aprendizaje automático en economía (lo siento, no es una charla pública y no tengo transparencias que pueda circular), escribir una serie de dos entradas en NeG sobre los mismos me sirve para pulir la introducción a la misma. Dada la extensión del material a cubrir, hoy hablaré sobre el aprendizaje automático más en general y la semana que viene sobre el aprendizaje profundo que esta detrás de AlphaGo.

El aprendizaje automático es un conjunto de algoritmos diseñados para permitir que un código de ordenador aprenda sobre patrones en los datos. En vez de especificar una larga lista de atributos de los objetos a estudiar (como hacían los sistemas expertos antiguos), los algoritmos de aprendizaje automático comienzan con un simple modelo del mundo para clasificar observaciones y una serie de reglas para modificar tal modelo según el éxito del mismo. Dado que la mayoría de los ejemplos en los libros y en internet no son de economía y que los lectores de este blog podrán, llegados a este momento, estar preguntándose qué tiene todo esto que ver con nuestro campo de investigación, déjenme que les de un ejemplo. De hecho este ejemplo es el que empleo en mi propio trabajo.

Imaginémonos que disponemos de una base de datos muy amplia de la estructura financiera de empresas, como Compustat. Esta base de datos nos suministra información sobre el capital, deuda, bonos, ventas, crecimiento, etc. de un amplio abanico de empresas a lo largo de varias décadas. La cantidad de información en la misma es tremenda. El procedimiento tradicional de los economistas para analizar empíricamente tal información se ha basado en dos líneas de ataque.

Una primera línea de ataque

La primera línea de ataque, a veces llamada de forma reducida, busca especificar regresiones entre distintas variables observadas basándose en una mezcla de intuición y ligera teoría. Por ejemplo, el investigador regresa el apalancamiento de la empresa contra su tasa de crecimiento o la industria en la que opera. La idea es que, por ejemplo, si una empresa crece deprisa es probable que quiera apalancarse para aprovechar las oportunidades y financiar tal crecimiento. Este bien citado trabajo de Murray Frank y Vidhan Goyal es un ejemplo representativo de esta estrategia empírica.